在这个选修部分中,我们将研究如何我们将对用于近似策略梯度的目标函数进行微分。

让我们首先回顾一下我们的不同公式:

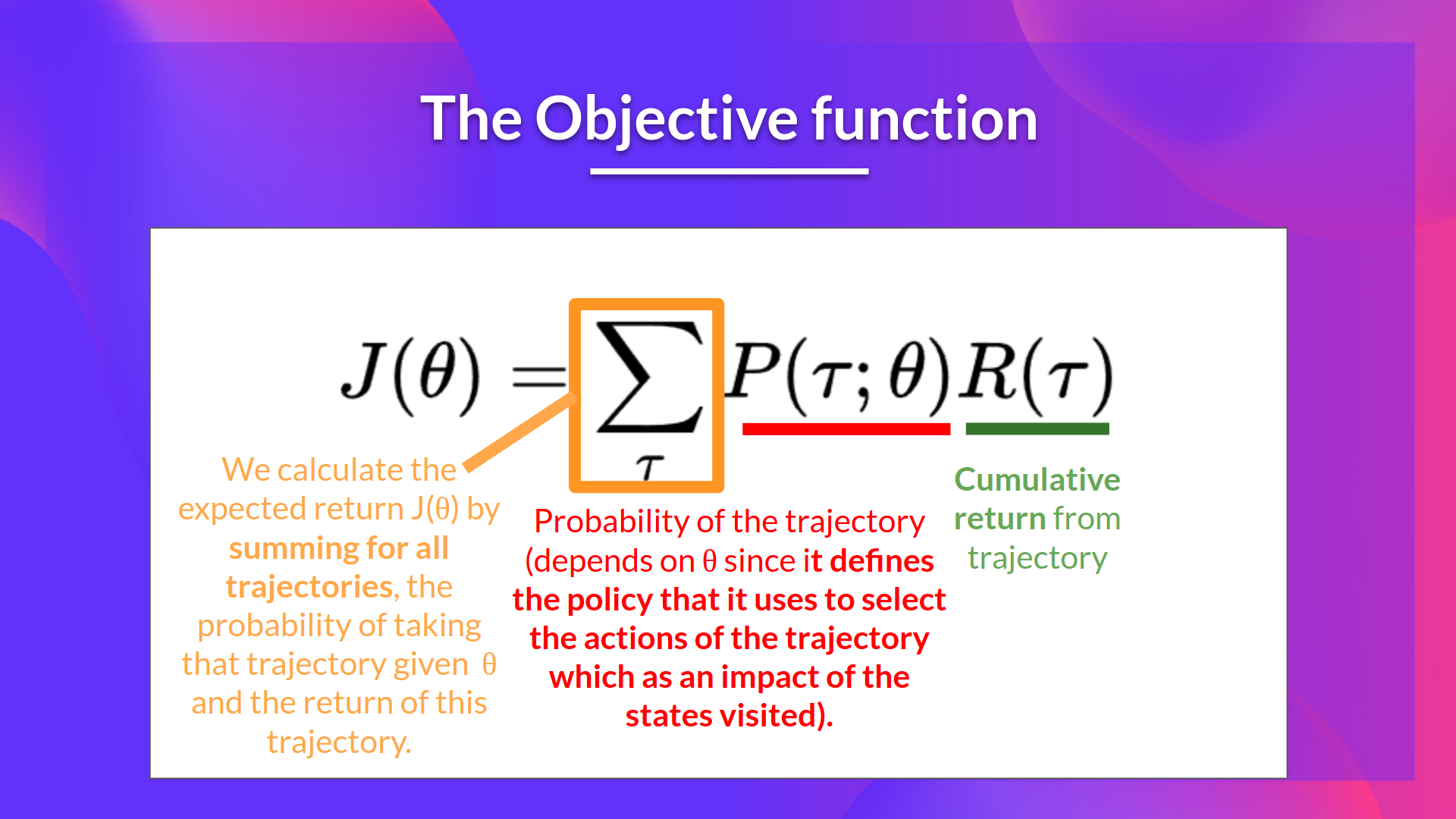

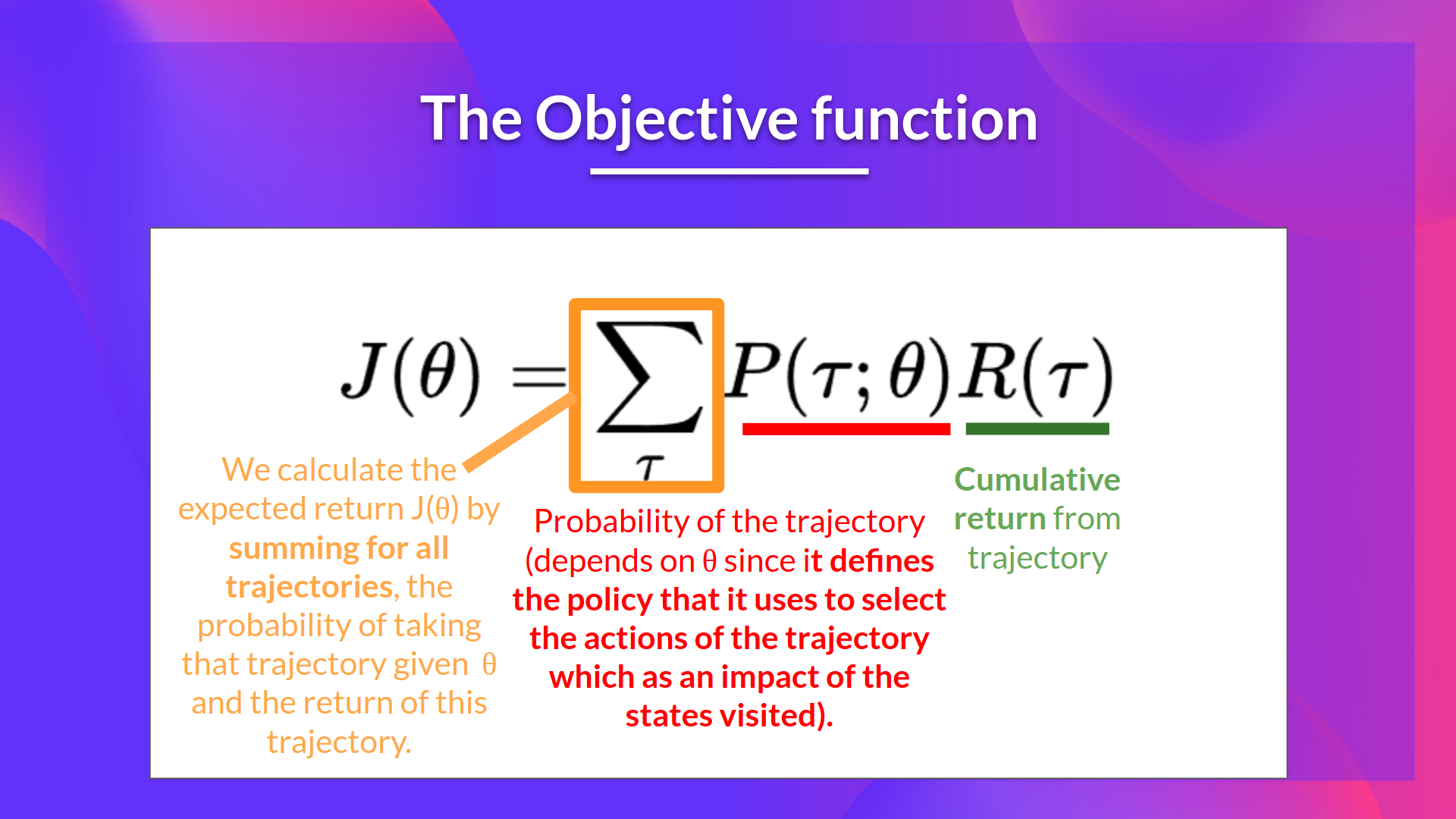

- 目标函数

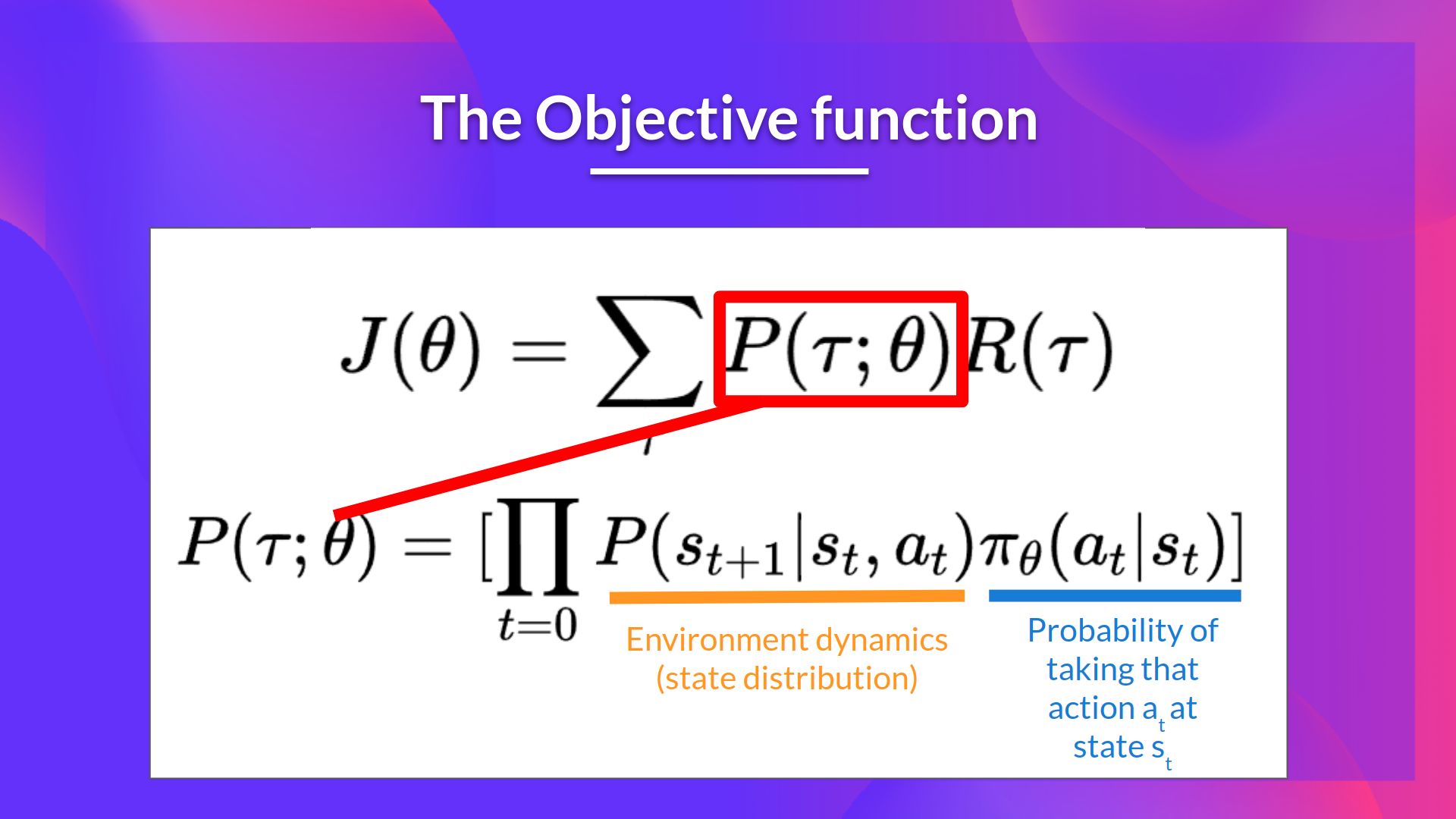

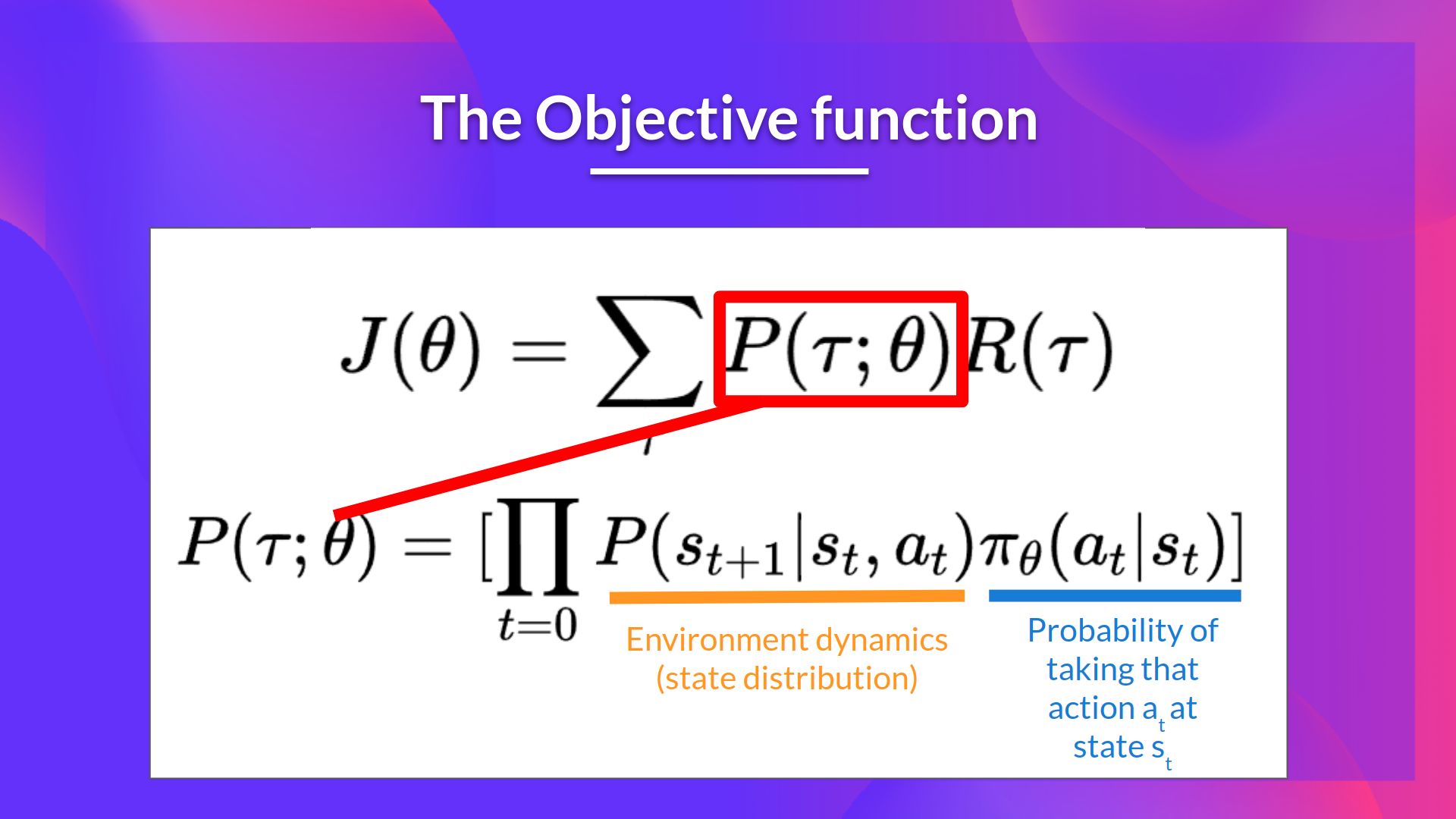

- 轨迹的概率(给定来自 \(\pi_\theta\) 的动作):

所以我们有:

我们可以将求和的梯度重写为梯度求和:

接着我们可以运用“对数求导技巧”(也称“似然比技巧”或“REINFORCE技巧”),

这是微积分中的一个简单规则,它意味着 $$\( \nabla_x log f(x) = \frac{\nabla_x f(x)}{f(x)} \)

因此,这就是我们的似然策略梯度:

感谢这个新公式,我们可以使用轨迹样本来估计梯度(如果你愿意,我们可以使用基于样本的估计来近似似然比策略梯度)

但是我们还有一些数学工作要做:我们需要简化 \( \nabla_\theta log P(\tau|\theta) \)

我们知道:

我们知道一个对数的乘积等于两个对数之和:

我们也知道和的梯度等于梯度的和:

由于 MDP 的初始状态分布或状态转换动力学都不依赖于 \(\theta\) ,两项的导数都是 0。因此我们可以移除它们:

因此:

我们可以将求和的梯度重写为梯度求和: